Twitterのホームタイムラインを取得して, 顔認識とツイートを定期的に実行する仕組みをサーバーレス環境 (GCP) に実装しました.

(意訳:推しの画像をリツイートしてみんなに見てもらいたかった@pedigree_C)

推しの方々からいいねをもらったりもらわなかったり, 評判がなかなか良いです(?)

全体のソースコードと詳細は https://github.com/camberbridge/dft-gcp-serverless にありますのでよろしければご覧ください.

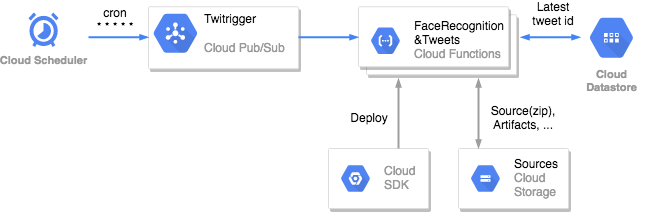

アーキテクチャ

何と言っても特筆すべきは Cloud Functions の柔軟さです.

関数が何らかの原因でクラッシュしても, 「失敗時に再試行」の設定をしておけば最大7日間 (2021年現在), 関数が正常に完了するまで繰り返し呼び出されます (タイムアウト時間は設定可能).

また, リクエストの多さによってインスタンス数が自動でスケールします. もちろんこの時の上限数は設定可能です.

今回は, 毎分の小さな定期実行なのでスケーリングしなくても間に合うだろうと思っていましたが, 画像付きツイートが多いと (顔認識があるので) 関数の処理に時間がかかって次のリクエスト処理に間に合わないことが多々ありました.

そんなときに Cloud Functions は自動でスケールアウトして, 逆に画像付きツイートが少ないとスケールインしてくれて, 非常に便利でした.

サーバーレス環境 (GCP)

DBにCloud Datastore

Twitterのホームタイムラインを定期的に取得する際, 前回取得したTweet IDよりも新しいものだけを取得するようにしたかったので, 最新のTweet IDを保持しておく必要がありました.

そこで, (DBを用意するまでもない構成ですが) 環境をステートレスにしたかったこともあり, ドキュメントDBの Cloud Datastore を用いました$^1$.

Tweet IDを書き込むときはデータを増やす理由がないので同じエンティティを更新し続けるようにしました.

ベストプラクティス的には, 「1つのエンティティをあまり頻繁に (1秒に1回以上) 更新しないこと」とありますが, ここでは毎分の更新なので良しとします$^2$.

1 | from google.cloud import datastore |

※ローカル環境から Datastore にアクセスする (上のコードを実行する) 場合はサービスアカウントを発行する必要があります$^3$

プログラムの実行環境にCloud Functions

イベント単位の実行に適したサーバーレスコンピューティングリソースの Cloud Functions を用いました.

基本的にはGCPコンソールで作成と設定が可能ですが, 顔認識に必要なOpenCVのDNNモデル等のファイルをコンソールからアップロードできません.

そこで, ソースコードやアセットをzip化したファイルを gsutil で Cloud Storage にアップロードしておき, その後の gcloud による Functions デプロイ時に, オブジェクトURLを指定してあげます$^4$.

1 | zip -r [FILE_NAME].zip * |

定期実行のトリガーにCloud Scheduler x Pub/Sub

cronと同じ要領で使える Cloud Scheduler から毎分 Pub/Sub トピックをパブリッシュして Cloud Functions をトリガーさせました.

トピックは gcloud コマンドでデプロイする時に作成 (Pub/Sub_TOPIC_NAME の部分) しており, 受けの Functions にも設定しているので, あとは出す側の Cloud Scheduler の設定をします.

やり方は, GCPコンソールでリージョンやcron, トピックを指定するだけです$^5$.

その他

デプロイ時やプログラム実行時の成功/失敗など, ログ監視に Cloud Logging が大変役に立ちます.

また, エラー確認には, Cloud Error Reporting がすごく便利です. Twitter APIにレート制限があることをすっかり忘れていて, 実際に Error Reporting からメールが届いたおかげで気づけました (後述の wait_on_rate_limit を設定したきっかけ).

Twitter API (Tweepy)

レート制限の対処

無料アカウントの場合, ホームタイムライン取得リクエストの制限回数は15分に15回 (2021年現在) です$^6$.

結構シビアですが, Tweepyにはレート制限が補充されるのを自動的に待つ (エラーハンドリングせずに放置できる!) 便利なパラメータ wait_on_rate_limit があるのでそれを使います$^7$.

1 | import tweepy |

ホームタイムライン取得

今回の仕組みは定期実行させるので, 毎度同じツイートを取得する可能性があります.

そこで, これまた便利なパラメータ since_id を使い, あるIDよりも新しいツイートを取得するようにします.$^7$

1 | timeline = api.home_timeline(since_id=TWEET_ID, count=N) |

ツイート前処理とMedia URLの取得

推しが投稿するツイートだけを取得したいので, 前処理として”RT @”を含むツイートを除外します.

ちなみにただのリツイートはホームタイムライン取得のレスポンスには入ってきません.

1 | for status in timeline: |

引用リツイート

元ツイートのURLをTweet本文に貼るだけで引用リツイートになります.

そしてアプリでリツイートした時と同様に, きちんと引用されたユーザに通知されます.

顔認識 (OpenCV DNN)

Web画像の読み込み

OpenCVでいろいろと画像処理をするため, Media URLから画像を一時ファイルとしてダウンロードしました.

このとき画像は /tmp ディレクトリに保存することがポイントです.

これは, Cloud Functions のファイルシステムで書き込み可能な場所 (一時ファイルの保存先として使用できる場所) は /tmp ディレクトリだけとなっているからです$^8$.

そして画像ファイルをOpenCVで読み込み, 処理の高速化のためあらかじめサイズを半分にしておきました.

1 | import numpy as np |

OpenCV DNNに入力する画像を正方形にリサイズ

画像をOpenCV DNNに入力する前に, 画像を正方形にリサイズしておく必要があります.

OpenCV DNNの顔認識では最初にBlobオブジェクトを blobFromImage() で作るのですが, このときの処理が同じ幅と高さの画像を要するからです$^9$.

1 | img_size = 600 |

顔認識の実行

検出結果それぞれには信頼度があるので, それをよしなに使います.

いろいろと試行錯誤した結果, 0.9よりも大きければ顔と判定することにしました. 今のところ仕組みは顔写真付きツイートだけに反応できているのでいい感じです.

# 事前学習済み DNN caffe model

# 参考: https://github.com/spmallick/learnopencv/tree/master/FaceDetectionComparison/models

PROTOTXT_PATH = "./deploy.prototxt"

WEIGHTS_PATH = "./res10_300x300_ssd_iter_140000_fp16.caffemodel"

# 信頼度閾値

CONFIDENCE = 0.9

face_num = 0

# モデルのロード

net = cv2.dnn.readNetFromCaffe(PROTOTXT_PATH, WEIGHTS_PATH)

net.setInput(blob)

detections = net.forward()

for i in range(0, detections.shape[2]):

confidence = detections[0, 0, i, 2]

# 顔検出

if confidence > CONFIDENCE:

face_num += 1参考文献

[1] “Datastore mode Client Libraries”. https://cloud.google.com/datastore/docs/reference/libraries

[2] “ベストプラクティス - エンティティの更新”. https://cloud.google.com/datastore/docs/best-practices#updates_to_an_entity

[3] “Datastore mode Client Libraries - Setting up authenticaiton”. https://cloud.google.com/datastore/docs/reference/libraries#setting_up_authentication

[4] “Google Cloud Pub/Sub トリガー - 関数のデプロイ”. https://cloud.google.com/functions/docs/calling/pubsub#deploying_your_function

[5] “Pub/Sub を使用して Cloud ファンクションをトリガーする - Cloud Schedulerジョブを作成する”. https://cloud.google.com/scheduler/docs/tut-pub-sub#create_a_job

[6] “Get Tweet timelines - Resource Information”. https://developer.twitter.com/en/docs/twitter-api/v1/tweets/timelines/api-reference/get-statuses-home_timeline

[7] “Tweepy API Reference”. https://docs.tweepy.org/en/latest/api.html

[8] “Cloud Functions 実行環境 - ファイルシステム”. https://cloud.google.com/functions/docs/concepts/exec#file_system

[9] “OpenCV Deep Neural Network module”. https://docs.opencv.org/master/d6/d0f/group__dnn.html